一、LM Studio安装及部署

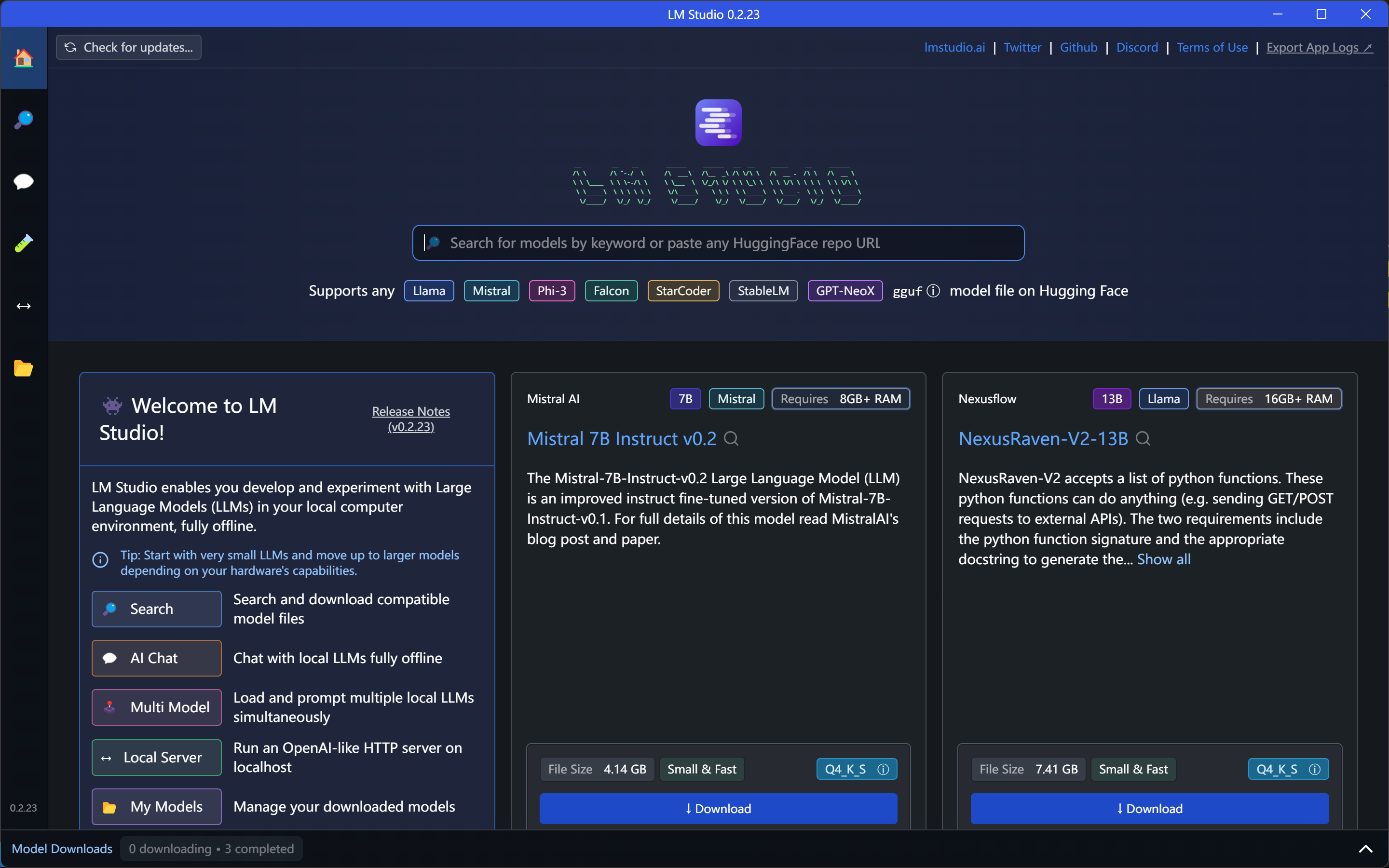

LM Studio是一款桌面软件,用于在本地计算机运行大模型,点击查看网址。安装好后首页如图所示,在此处即可下载大模型。

1.下载和管理大模型

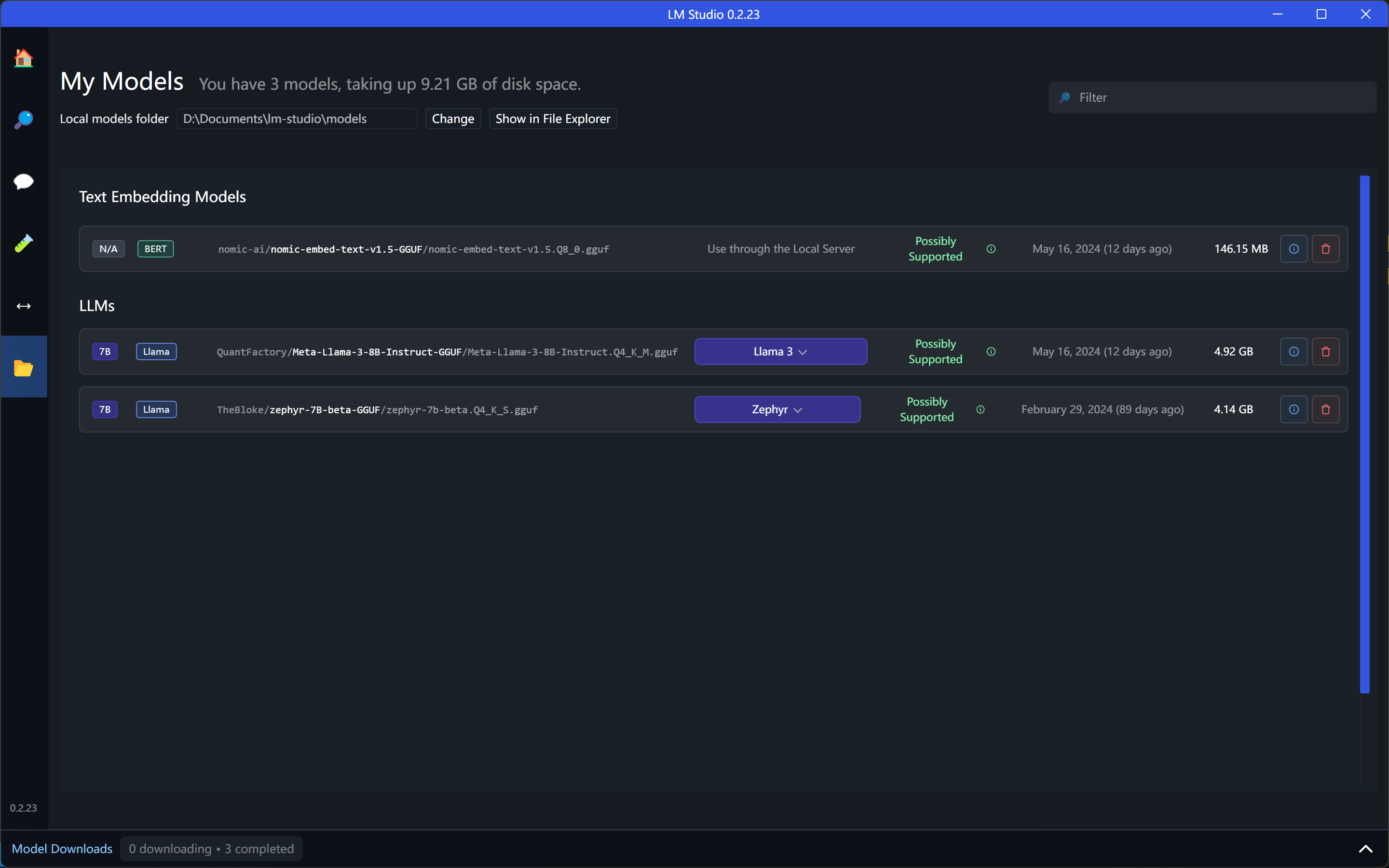

要想构建本地知识库,我们需要用到两类大模型,一个适用于对话的大语言模型:c,一个是用于将文本向量化的大模型nomic-ai.nomic embed text v1 5 Q8_0 gguf。我下载了下图所示的两个大模型。直接在首页搜索或查找下载即可。

- 值得注意的是:我在下载的时候会出现网络问题,简单的科学上网无法解决,最后使用了proxifier才解决

下载好后,可以在左侧进入对话界面,进入之后在上方选择下载好的大模型,即可开始对话。可以通过这一步骤验证是否成功安装好大模型。

2.运行服务器

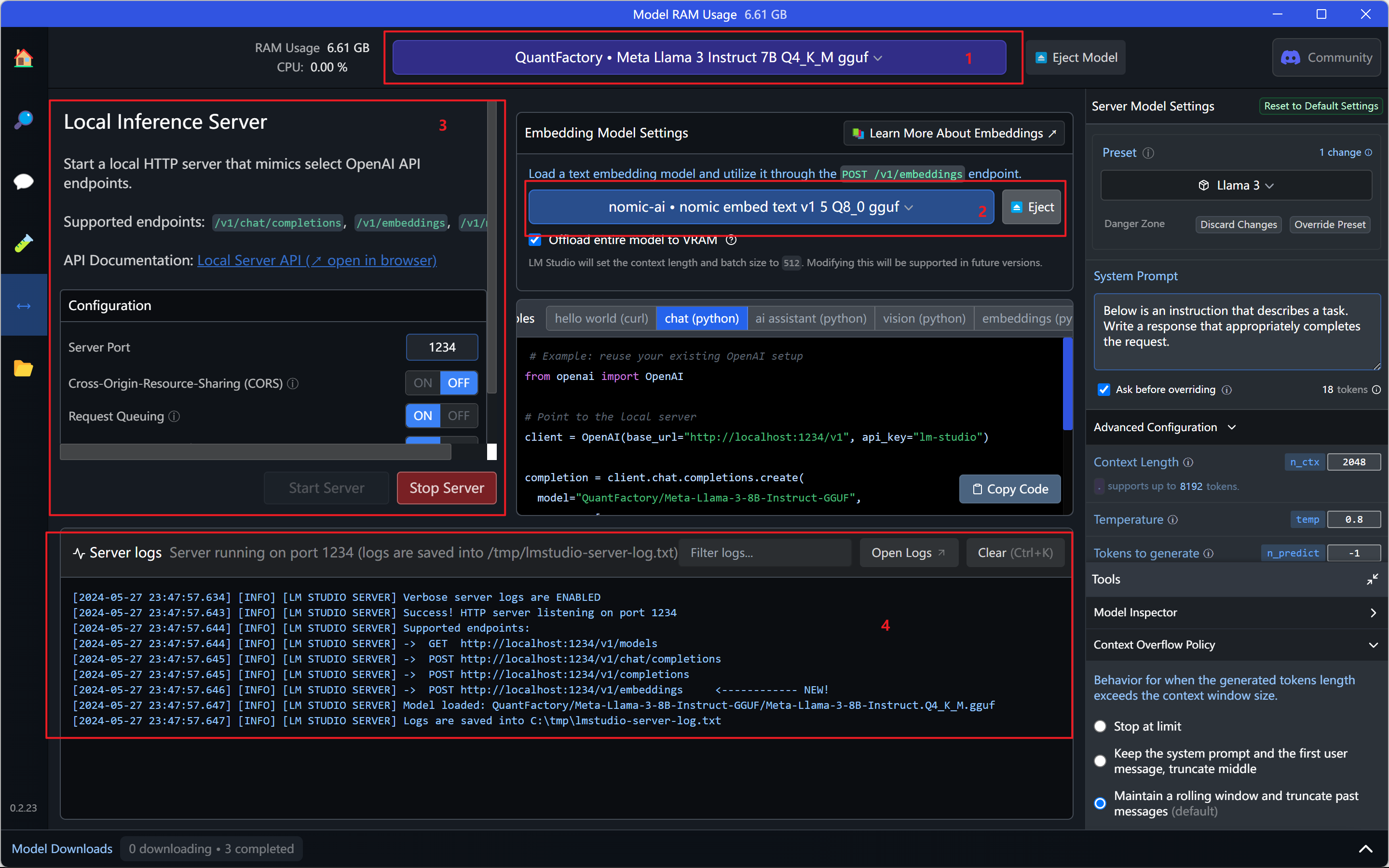

LM Studio的服务器功能允许用户开启一个本地服务器,从而使得其他应用可以通过调用该服务器端口来访问和使用本地的大型语言模型。开启之后,才能够在AnythingLLM中调用上述步骤中下载的大模型。

- 选择下载的语言大模型:

Meta Llama 3 lnstruct 7B Q4_K_M gguf - 选择下载的嵌入大模型:

nomic-ai.nomic embed text v1 5 Q8_0 gguf - 配置端口,并启动服务器。这里的配置信息一般不需要做任何改动。

- 日志,可以查看模型的调用情况。每一次问答都会有记录。

二、AnythingLLM安装及部署

在LM Studio中启动服务器之后,就需要到AnythingLLM中来进行相关的配置。

Anything有桌面安装版和Docker部署两种方式。前者比较简单,点击查看网址进行安装。

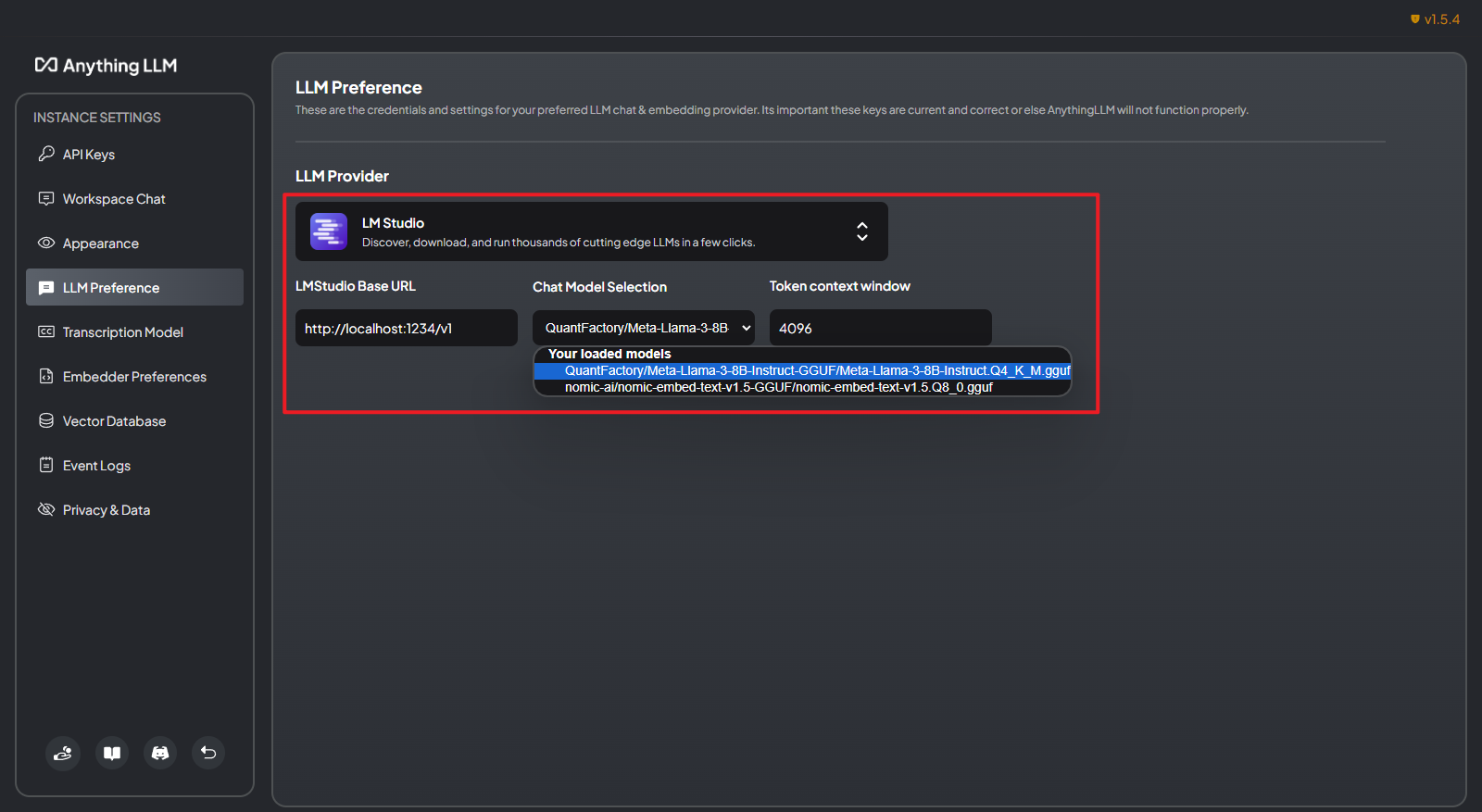

1.配置对话大模型

在左侧LLM Preference一栏配置对话大模型,选择LM Studio为LLM Provider,然后填入地址和端口,选择Meta Llama 3 lnstruct 7B Q4_K_M gguf模型,如图所示。

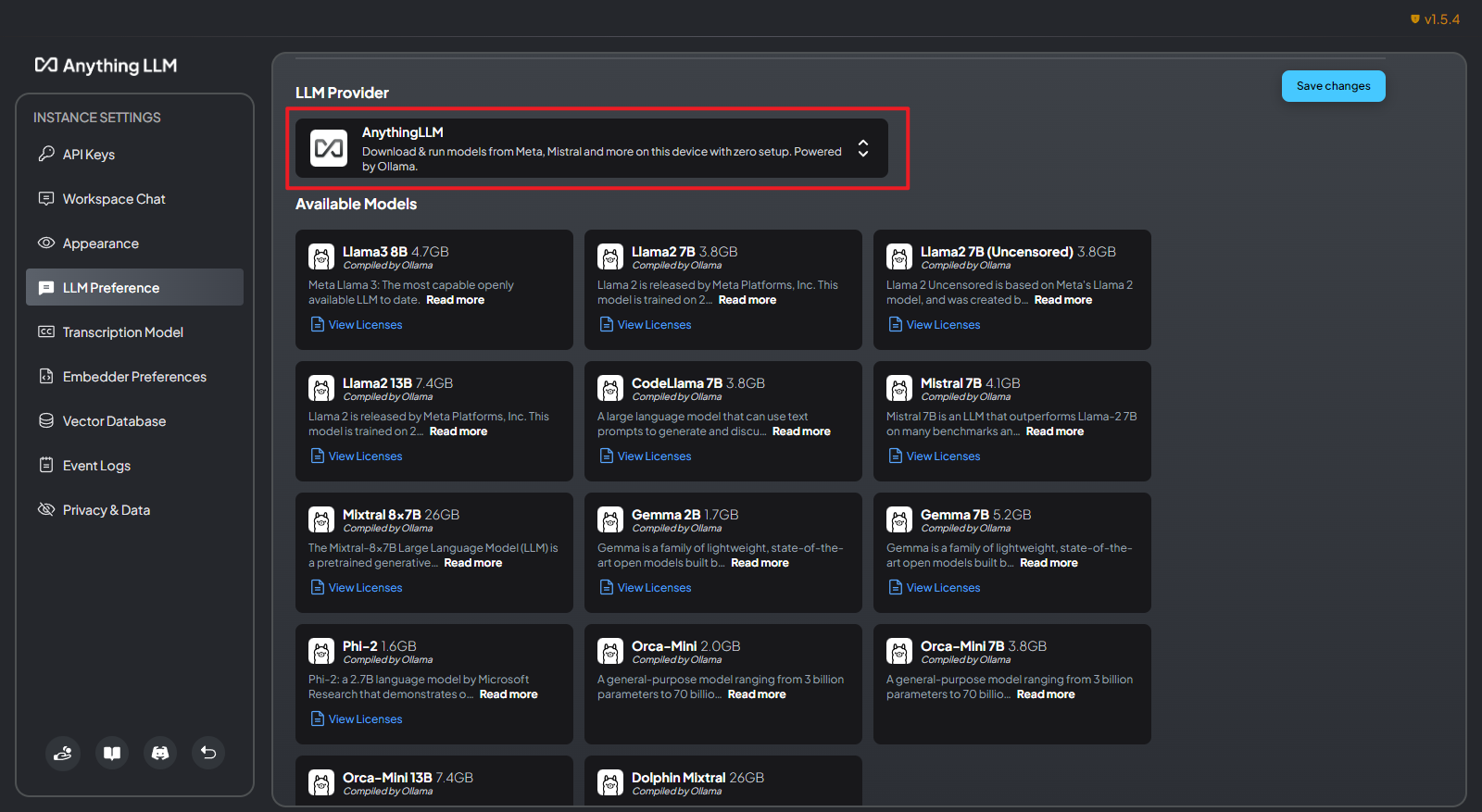

AnythingLLM是也是可以独立运行大模型的。在LLM Provider那一栏,你也可以直接选择AnythingLLM,也有不少的大模型可供下载。

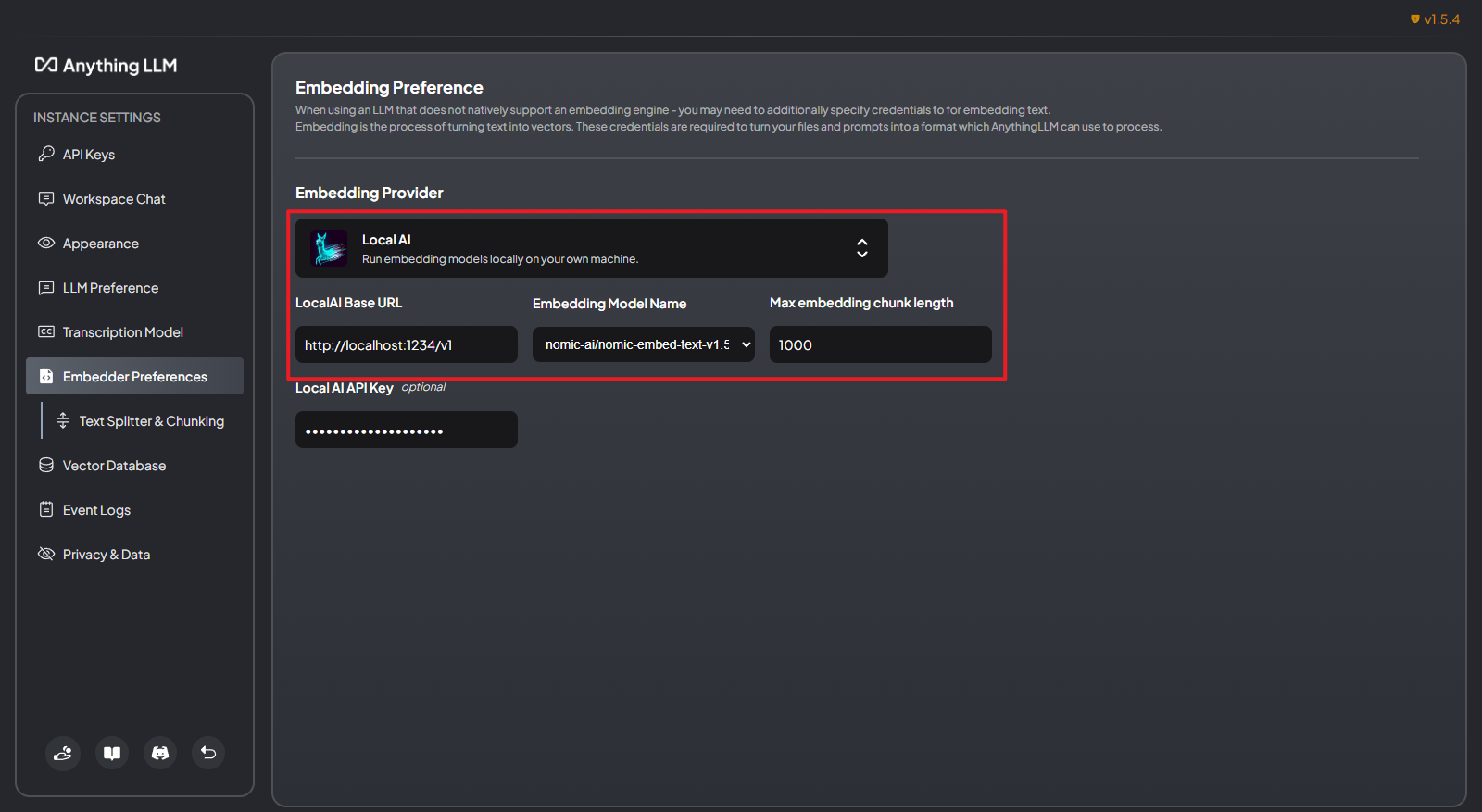

2.配置嵌入大模型

左侧点击Embedder Preferences进入设置界面,Embedding Provider选择Local AI,填入LM Studio服务器的接口,选择大模型,chunk length选择默认的1000(表示将文本向量化的时候,按照1000的长度来切分)。

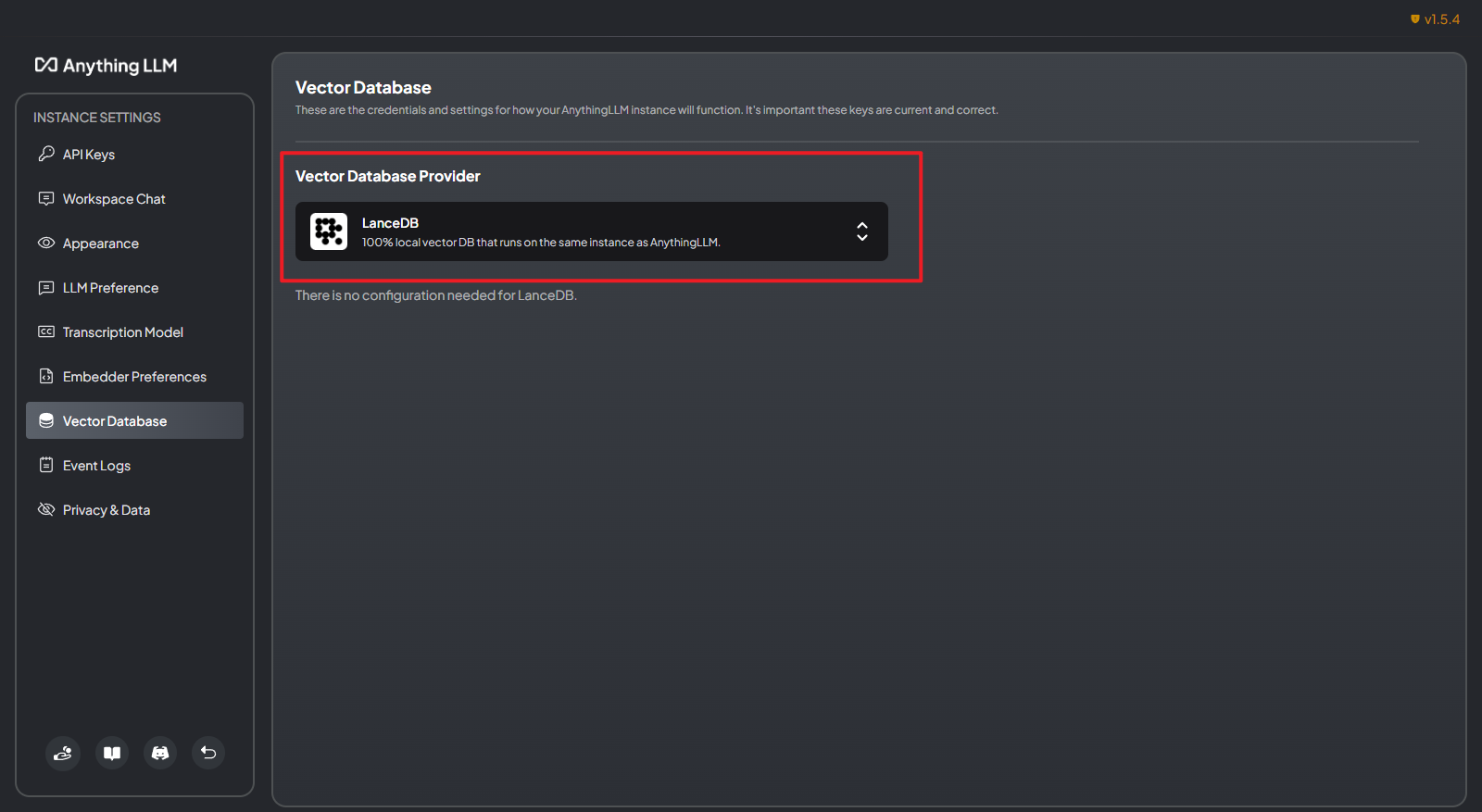

3.配置向量库

向量库用于存储和检索向量化的文本。这里选择一个轻量级的向量库LanceDB

4.配置知识库

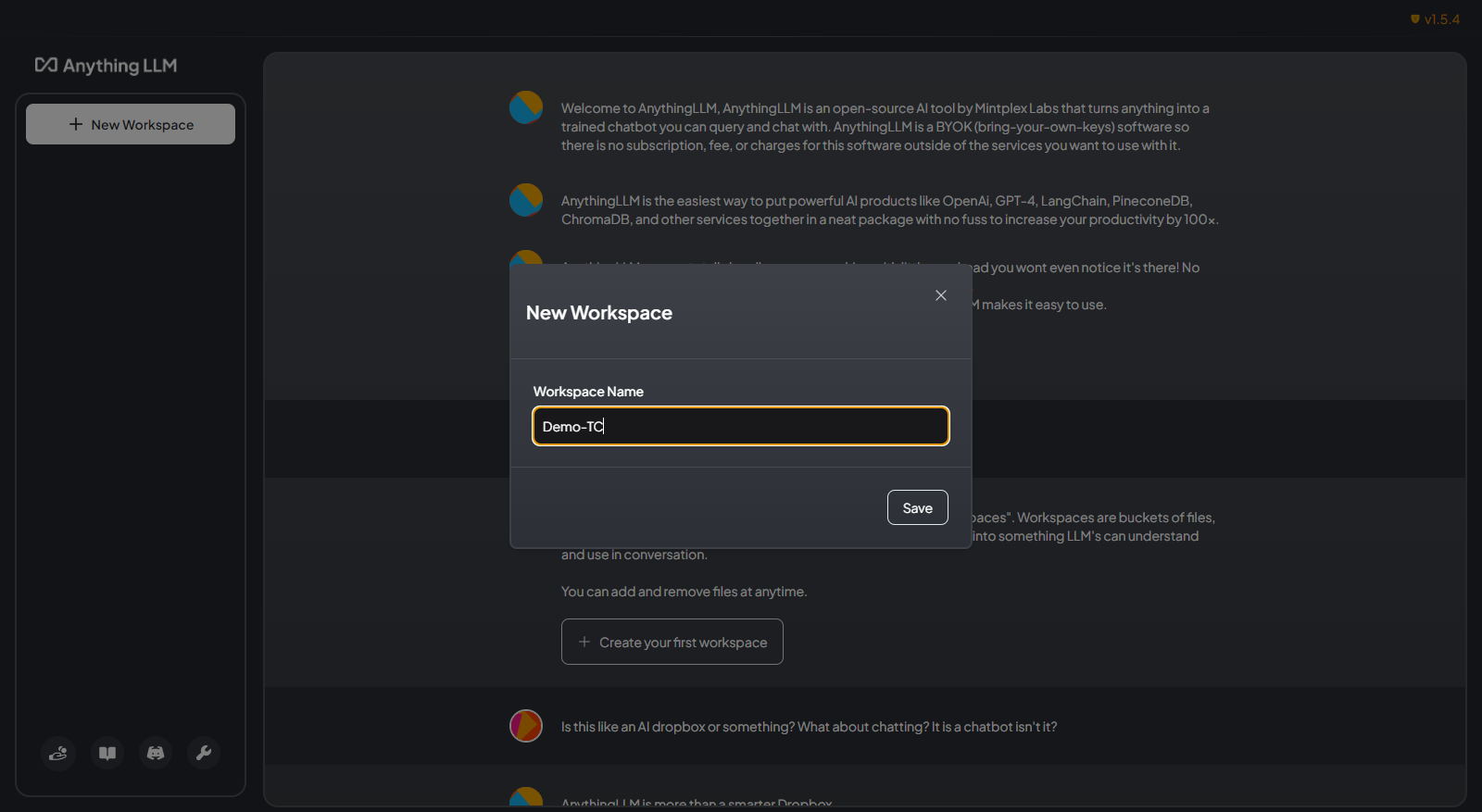

以上步骤完成之后,就可以进行知识库问答了。首先点击New Workspace,创建一个新的工作区。

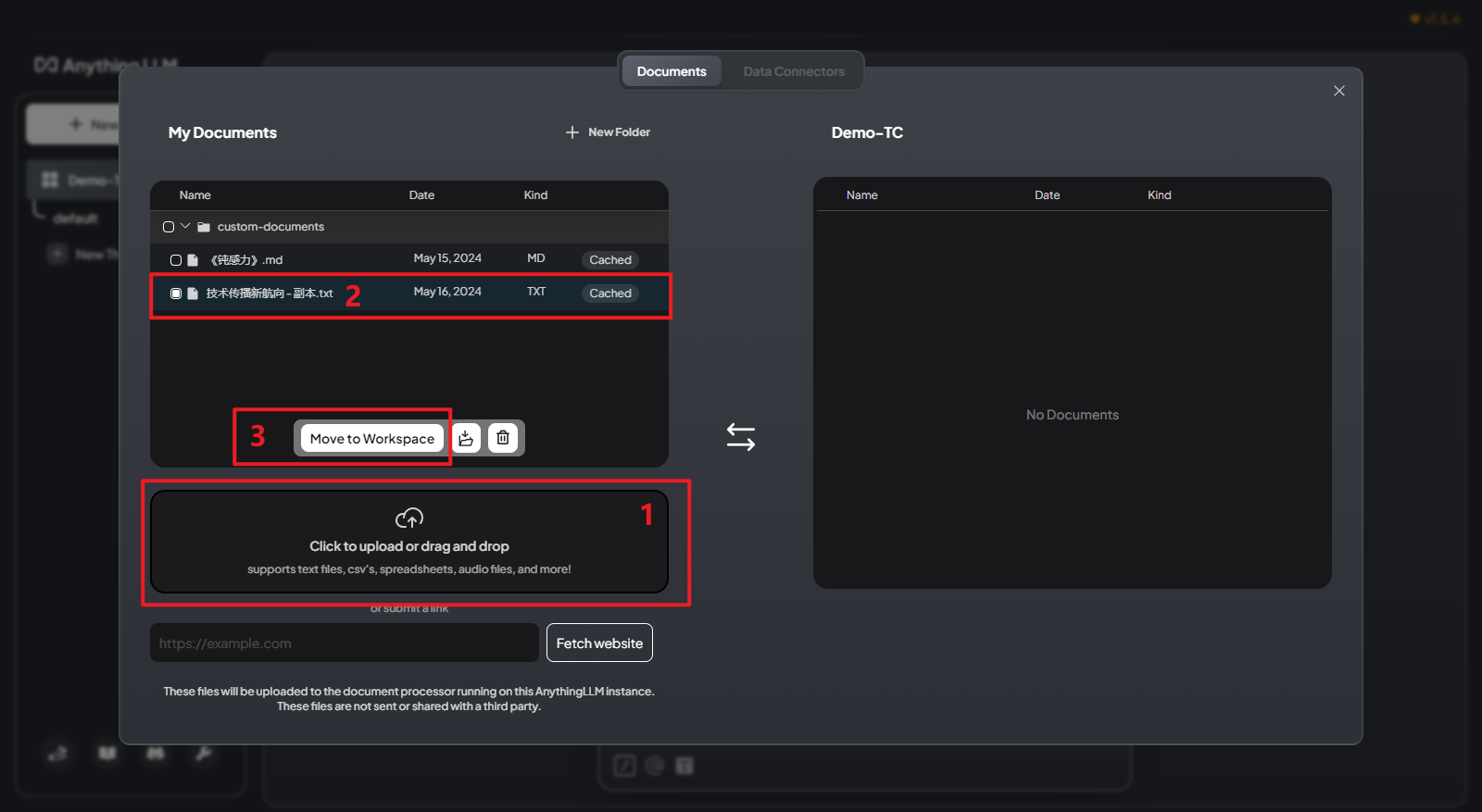

然后点击工作区名称旁边的上传按钮,在以下界面上传文件。

- 点击浏览上传或者直接拖拽文件上传整个文档库

- 点击选择需要保存到工作区的文件

- 点击Move to Workspace移动到工作区

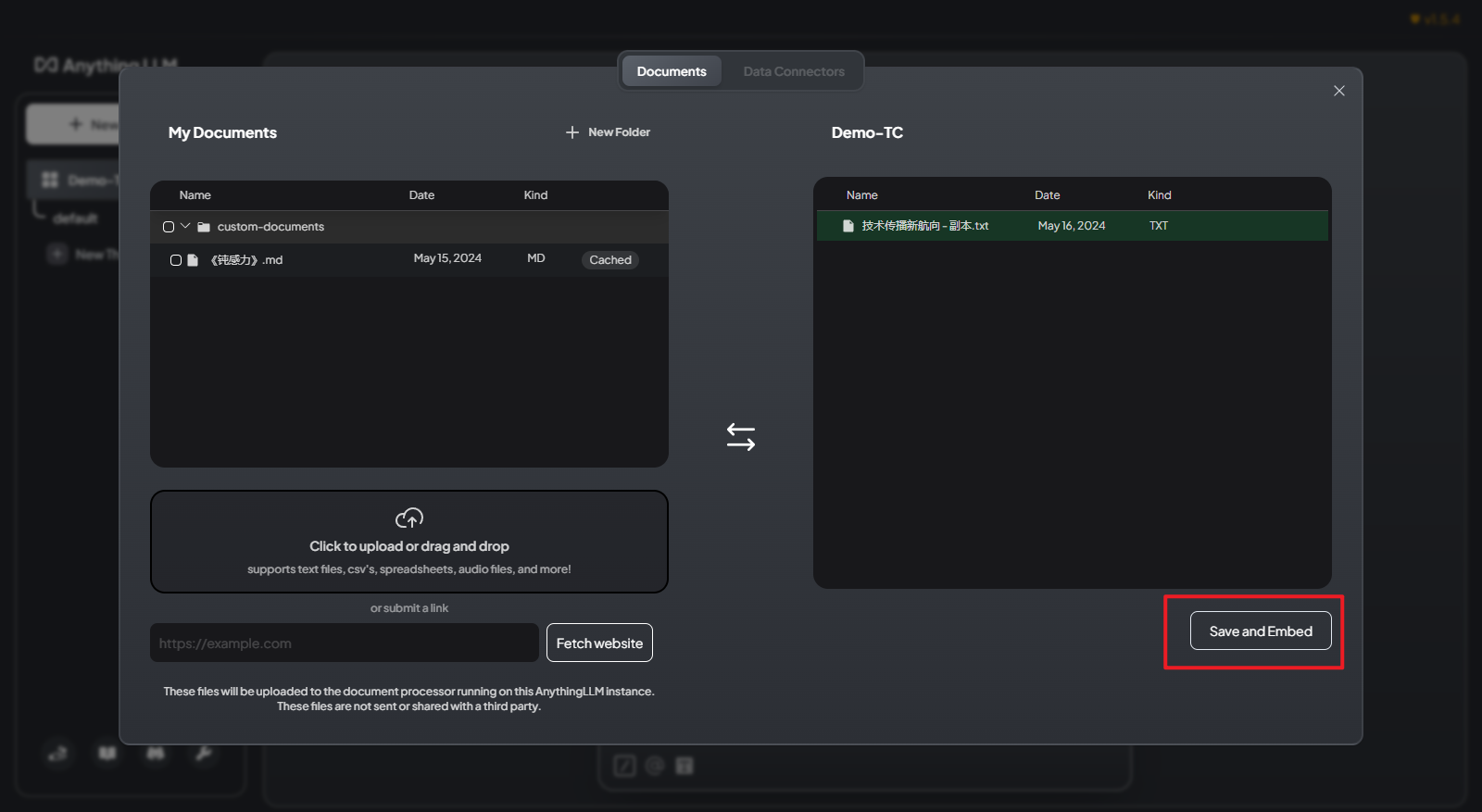

最终点击Save and Embed即可成功将文件中内容向量化并存储到工作区中。

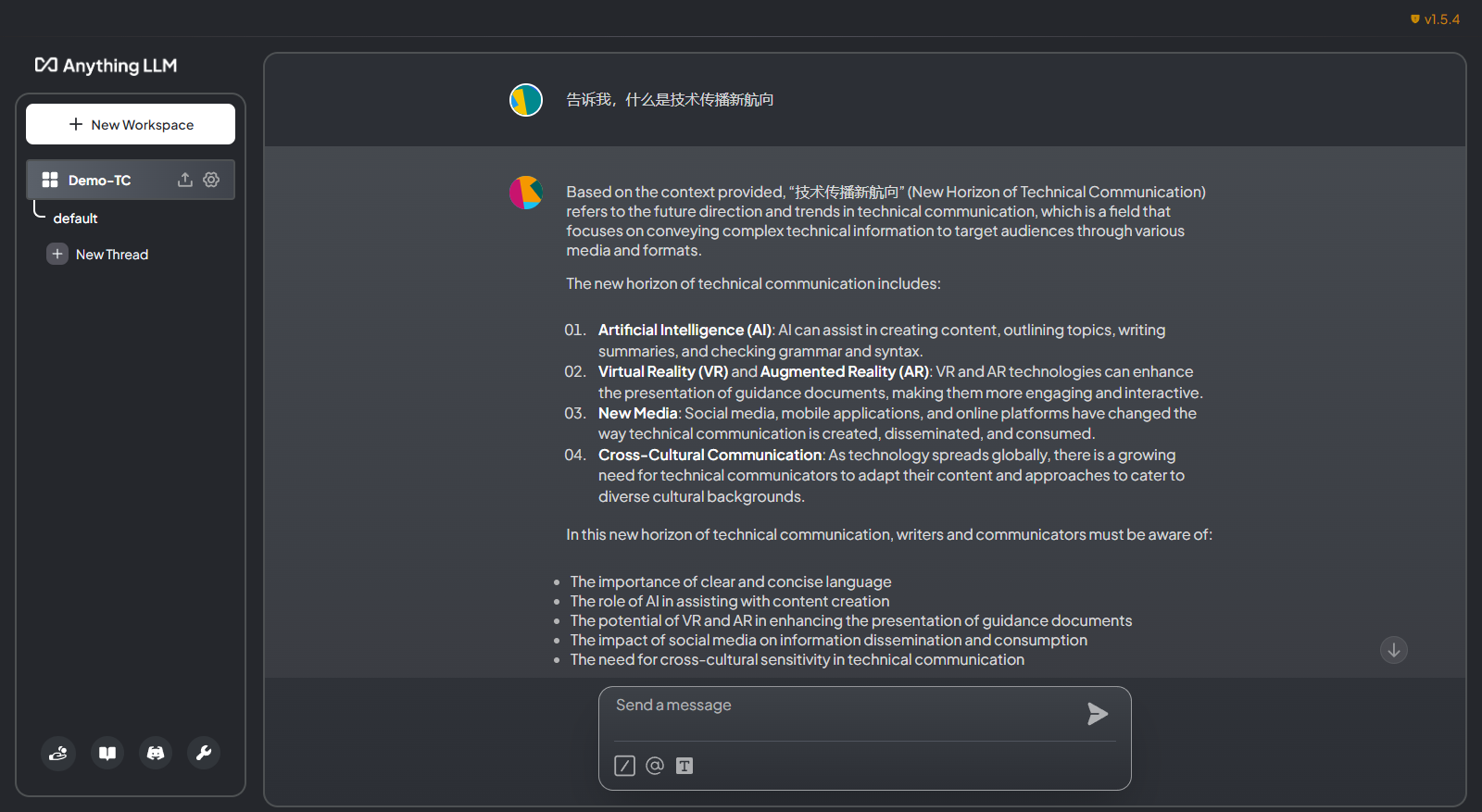

让我们来简单测试一下。我上传的文件是一篇科普文章,提问“告诉我,什么是技术传播新航向”,在回答中所有方面都涵盖到了,同时还对管内容进行了总结。

但是,缺点也很明显,反应会比较慢,毕竟笔记本性能一般,下载模型的参数也比较小。

不过好歹是本地化部署,可以保证私密性。比如可以读取一些自己的笔记文件,来帮助日常记录。

参考文章

使用LM Studio与Anything LLM基于Llama-3高效构建本地知识库系统 - DRBOOL的文章 - 知乎